25년 1월 1주차 그래프 오마카세

Google Research : Understanding Transformer reasoning capabilities via graph algorithms

Blog link : https://research.google/blog/understanding-transformer-reasoning-capabilities-via-graph-algorithms/

- 2025년 푸른 뱀의 해 (을사년) GUG 구독자 분들 모두 새해 복 많이 받으세요 !

- 25년 뱀의 해는 뱀의 유연한 움직임처럼 변화에 잘 적응하고 새로운 기회를 잘 잡아가는 해가 될 것이고, 지혜롭게 다가오는 도전과 변화를 마주하고 신중한 태도로 성장할 기회로 삼으라는 메시지를 전하는 해라고 하네요. 구독자 분들에게 좋은 메세지로 전달되기를 바랍니다.

- 새해 첫 그래프 오마카세로 구글 리서치에서 NeurIPS 2024에 발표한, 그래프 알고리즘을 통해 Transformer 추론 기능을 이해하고, 다양한 그래프 작업에서 Transformer가 GNN보다 언제, 어디서 더 나은 성과를 낼 수 있는지에 대한 분석을 간략히 설명해준 블로그 글을 가지고 왔습니다.

- 해당 논문에서는 폭넓은 실험적 결과와 이를 뒷받침해주는 이론적 분석을 자세히 제공합니다. 특히 Transformer가 Global한 그래프 패턴을 효과적으로 포착하는 뛰어난 능력을 강조할 수 있다는 사실을 기반으로, Global 그래프 구조 정보가 핵심적인 다양한 그래프 도메인 작업을 해결하는 데 중요한 요소인 장거리 종속성 (Long Range Dependency)을 이해하는 능력을 보여줍니다.

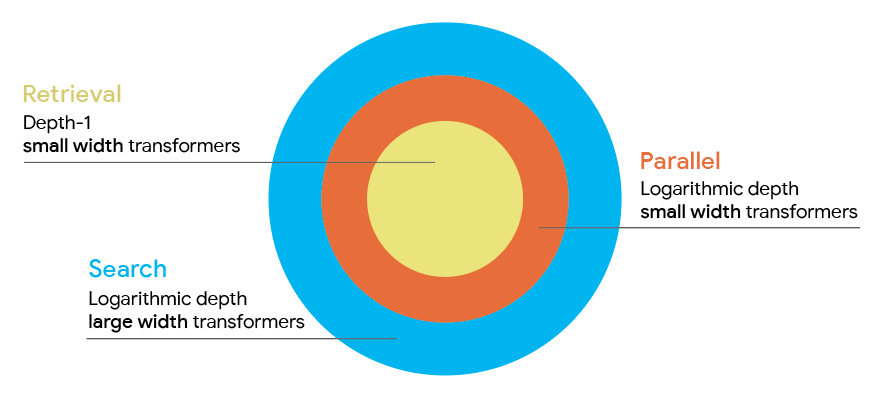

- 아래 그림과 같이, Transformer의 깊이에 따른 추론, 병렬화, 탐색 등의 영역을 적절한 파라미터 효율적 방식 (parameter-efficient manner)을 유지하면서 GNNs보다 뛰어난 성과를 달성할 수 있음을 보인 점이 눈에 띄었습니다. 해당 블로그 글을 참조하시면서 논문을 읽어보시면 그 인사이트를 쉽게 얻어가실 수 있으리라 생각합니다.

We find that transformers can solve parallelizable tasks (like connectivity) in a highly parameter-efficient manner and outperform graph neural networks (GNNs) on tasks that require the analysis of long-range dependencies.

We also introduce a novel representational hierarchy of graph reasoning tasks that formalizes reasoning capabilities of transformers in several realistic parameter scaling regimes.

- 올 한해에도 더욱 발전해가는 그래프 머신러닝 연구 결과를 여러분들께 공유해드리면서 핵심 키워드를 쉽게 이해하고, 같이 논의하면서 그래프 오마카세 컨텐츠와 같이 성장해갈 수 있었으면 좋겠습니다.

[Contact Info]

Gmail: jhbae1184@akane.waseda.jp

Twitter (X): @jhbae1184