25년 1 월 3주차 그래프 오마카세

- 안녕하세요. 이번 주 오마카세에서는 SNS 상에서 많은 연구자들로부터 뜨거운 관심을 받으면서 빠르게 공유되고 있는 2가지 게시글과 개인적으로 구독자 여러분들께 읽어보면 좋을 것 같은 논문 2가지를 공유해드리고자 합니다.

Don't Do RAG : When Cache-Augmented Generation is all You Need for Knowledge Tasks

X link : https://x.com/rohanpaul_ai/status/1876026885718868257

paper link : https://arxiv.org/abs/2412.15605

Podcast : https://x.com/rohanpaul_ai/status/1876026889724465428

- 기존 RAG의 요구되는 복잡한 아키텍처를 완화하기 위한 Cache-Augmented Generation (CAG) 기법을 소개하는 논문을 다루고 있습니다. 최근 RAG 전문가들 사이에서 많은 shout-out을 받고 있는 것 같습니다.

- 해당 게시글의 인사이트를 보면 아키텍처의 복잡성을 줄이기 위해 Retrieval 단계를 제거하는 대신, 미리 계산되어 저장되어 있는 참고 문서의 key-value 캐시를 로드하는 것으로 대체하는 것의 엄청난 효율성을 강조하고 있습니다. 실제로 생성 시간의 엄청난 단축과 동시에 일관되게 기존 방법들을 능가하는 결과를 얻어내었다고 합니다.

- Google Illuminate를 사용하여 생성된 Podcast 영상에서 해당 논문에 대한 요약을 (4분 가량) 제공하고 있으니, 같이 참고해보시면 좋을 것 같습니다.

Graph Generative Pre-trained Transformers (G2PT)

X link : https://x.com/fly51fly/status/1748714766489829574

paper link : https://www.arxiv.org/abs/2501.01073

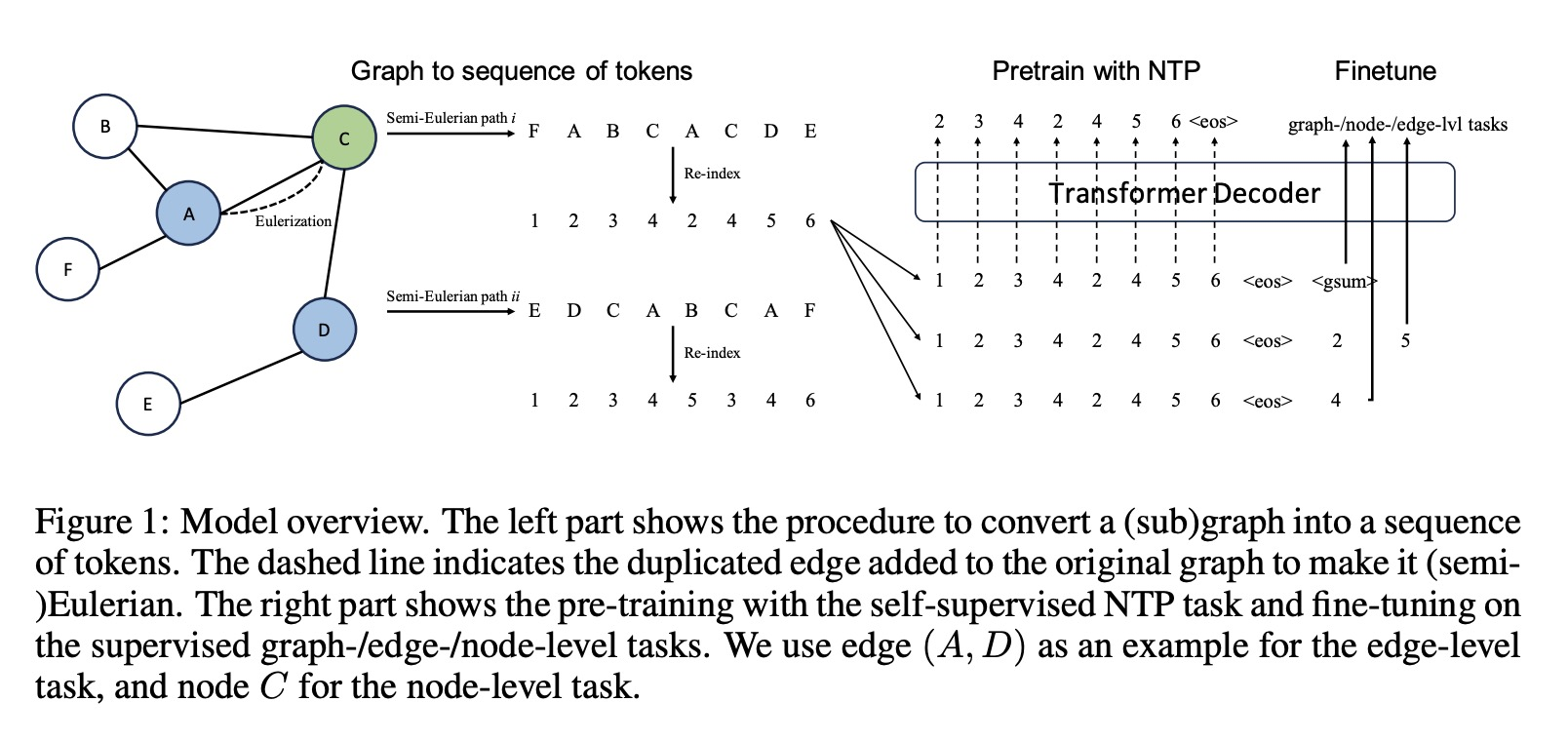

- 그래프 학습에 특화된 GPT 모델인 G2PT가 제안되었습니다. 오버뷰를 보면 Eulerian path (한붓그리기)을 통해 그래프 노드를 재인덱싱하고, 토큰화된 노드 시퀀스들을 트랜스포머 디코더에 입력시켜 NTP(Next Token Prediction) task에 대해 사전 학습합니다. 그리고 다양한 그래프 다운태스크를 위한 Fine-tuning 작업을 수행하는 것으로 이해해볼 수 있을 것 같습니다.

- Eulerian path를 활용하는 부분에서, 모든 노드를 지나갈 수 있는 특정 조건이 존재할 텐데 (차수 - degree가 홀수인 노드의 개수가 2개), 그래프 구조에 따라 도달하지 못하는 노드들에 대해서 어떻게 고려될 지 궁금하긴 했습니다.

- 해당 부분을 논문에서 찾아보니, 기존 엣지를 복제하여 Eulerization 과정을 통해 위의 조건을 만족하는 그래프 (Euler Graph)로 변환할 수 있음을 보여주고 있네요. 그로부터 그래프로부터 노드 토큰 시퀀스의 가역적 변환에 대한 손실 없는 직렬화가 가능하다고 합니다.

- 해당 글의 마지막 설명, Limitation을 보면 하위그래프 샘플링 및 컨텍스트 윈도우 사이즈 등의 의존도가 존재하는 것으로 보이며, 대상 데이터 자체에서만 사전 학습 후 미세 조정해야 하는 과정으로부터 Transferability 및 Application의 한계 제한점들이 존재합니다. 자세한 설명은 Appendix G.를 참고하시면 될 것 같습니다.

- 추가적으로 제가 구독자 여러분들께 개인적으로 읽어보시기를 추천드리는 그래프 논문을 공유드리고자 합니다.

- Generalizastion, Expressivity, and Universality of Graph Neural Networks on Attributed Graphs : 논문 이름 그대로 소셜 네트워크, 분자 구조 등과 같은 속성 그래프 (Attributed / featurized graphs)에 대한 GNN 모델의 일반화, 표현력, 그리고 보편성에 대한 자세한 연구 및 광범위한 실험 결과를 보이고 있습니다. 또 다른 GNNs의 강건한 성능을 확인해볼 수 있는 논문으로 가볍게 추천드리고 싶습니다.

- Scalable Message Passing Neural Networks : No Need for Attention in Large Graph Representation Learning : 트랜스포머 모델의 핵심 모듈인 어텐션 테크닉을 (다른 구성은 그대로 유지하면서) GCN 모듈로 바꾸어 적용하였을 경우에 거대 그래프 표현 학습에서 상당한 성능 향상을 얻어냈다는 결과를 강조하는 논문입니다. 기존 어텐션의 과도한 연산량을 가벼운 GCN 메커니즘으로 전환하여 메모리 효율성을 가져오면서 노드 간 메세지 전달 과정을 최적화하여 다양한 그래프 구조에 대한 정보를 효과적으로 캡처할 수 있음을 설명합니다.

[Contact Info]

Gmail: jhbae1184@akane.waseda.jp

Twitter (X): @jhbae1184