25년 6월 2주차 그래프 오마카세

Introducing KumoRFM: A Foundation Model for In-Context Learning on Relational Data

paper link : https://kumo.ai/research/kumo_relational_foundation_model.pdf

blog link : https://kumo.ai/company/news/kumo-relational-foundation-model/

- 저저번주 오마카세에서 소개해드렸던 관계형 그래프 트랜스포머(Relational Graph Transformer)에 관련한 블로그 글에 이어, KumoAI에서 관계형 데이터베이스를 위한 그래프 기반 KumoRFM을 발표한 게시글 내용을 가볍게 정리하여 공유해드립니다.

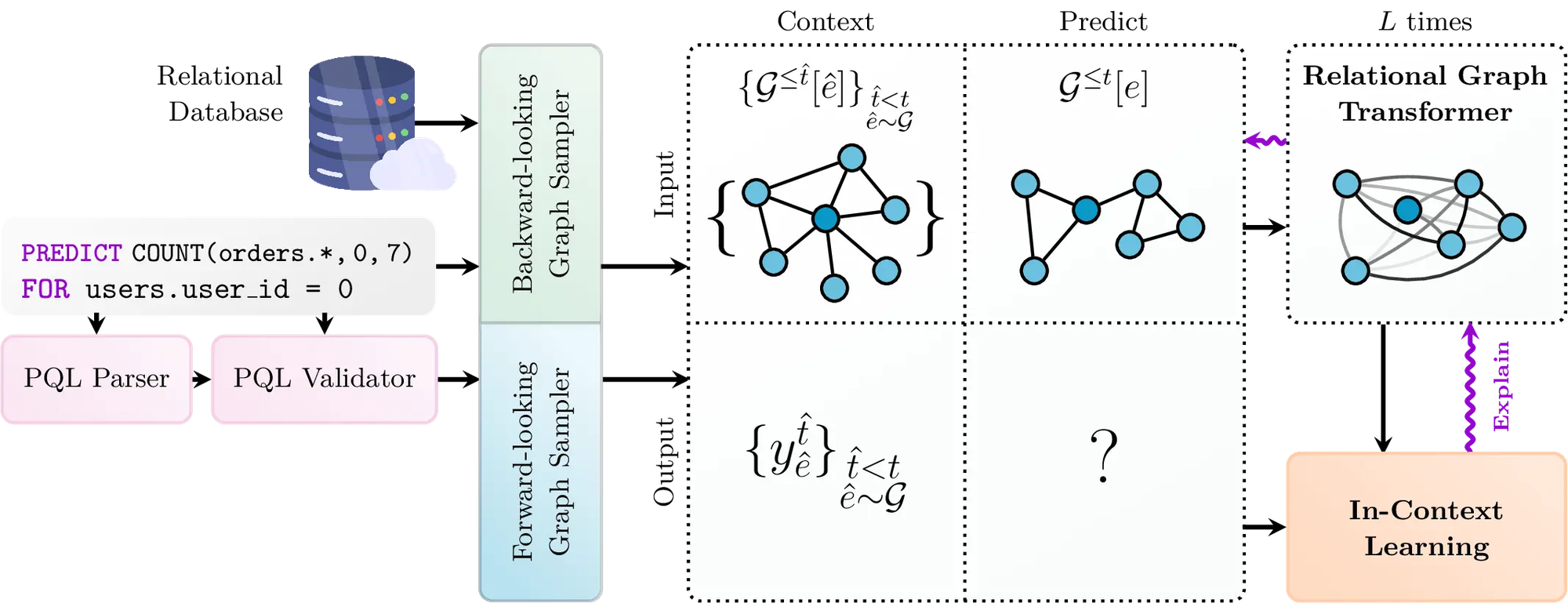

- 다음 모델은 노드 회귀, 노드 분류, 링크 예측 등의 다양한 그래프 문제들에 있어서 제로샷 방식으로 접근할 수 있습니다. 범주형 또는 수치형 특성을 갖는 관계형 테이블 집합을 그래프로 변환하면 위의 일반적인 작업을 제로 샷 방식으로 해결할 수 있음을 언급합니다.

- 다른 귀납적 모델과 비교했을 때, KumoRFM의 가장 큰 차이점은 in-context learning을 사용한다는 점입니다. 즉, 각 예측 작업에서 대상 엔티티 주변의 ego-graph뿐만 아니라, 유사한 레이블을 갖는 관련 노드를 포함하는 ego-graph도 같이 마이닝합니다. 노드 관련 작업에 대한 ego-graph를 인코딩하는 백본 모델로 위의 관계형 그래프 트랜스포머 모델을 활용하며, 출력된 벡터형태의 그래프 정보는 어텐션 풀링을 통해 집계됩니다.

- KumoRFM의 의사결정 단계에 있어서 그 투명성을 확보하기 위해 일종의 Graph explainer 도구도 내장되어 있습니다. 또한 특정 쿼리 또는 데이터셋에 맞게 특화된 파인튜닝도 가능하여 어느 로컬 환경에서나 맞춤형 동작이 가능한 편리성을 제공합니다.

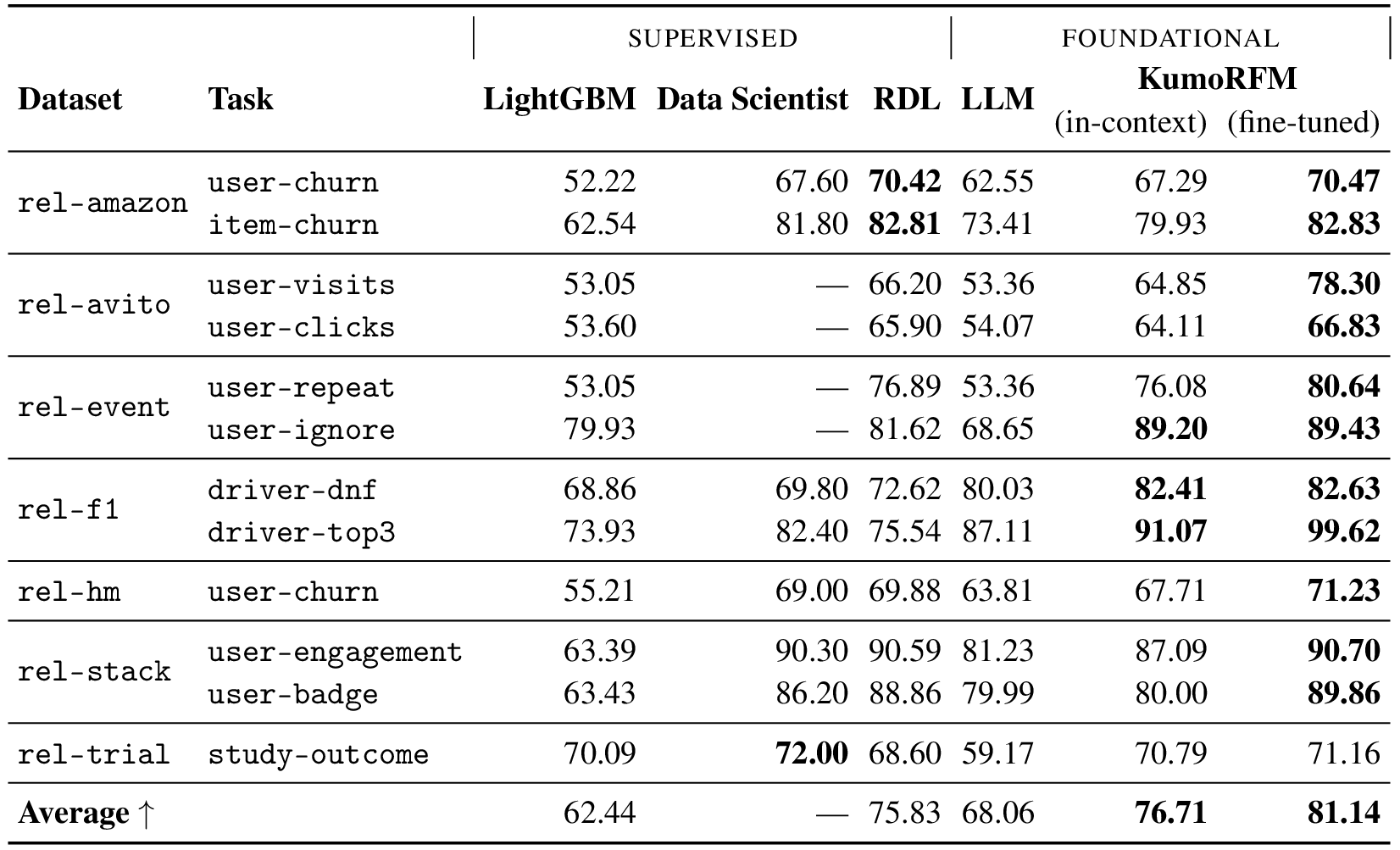

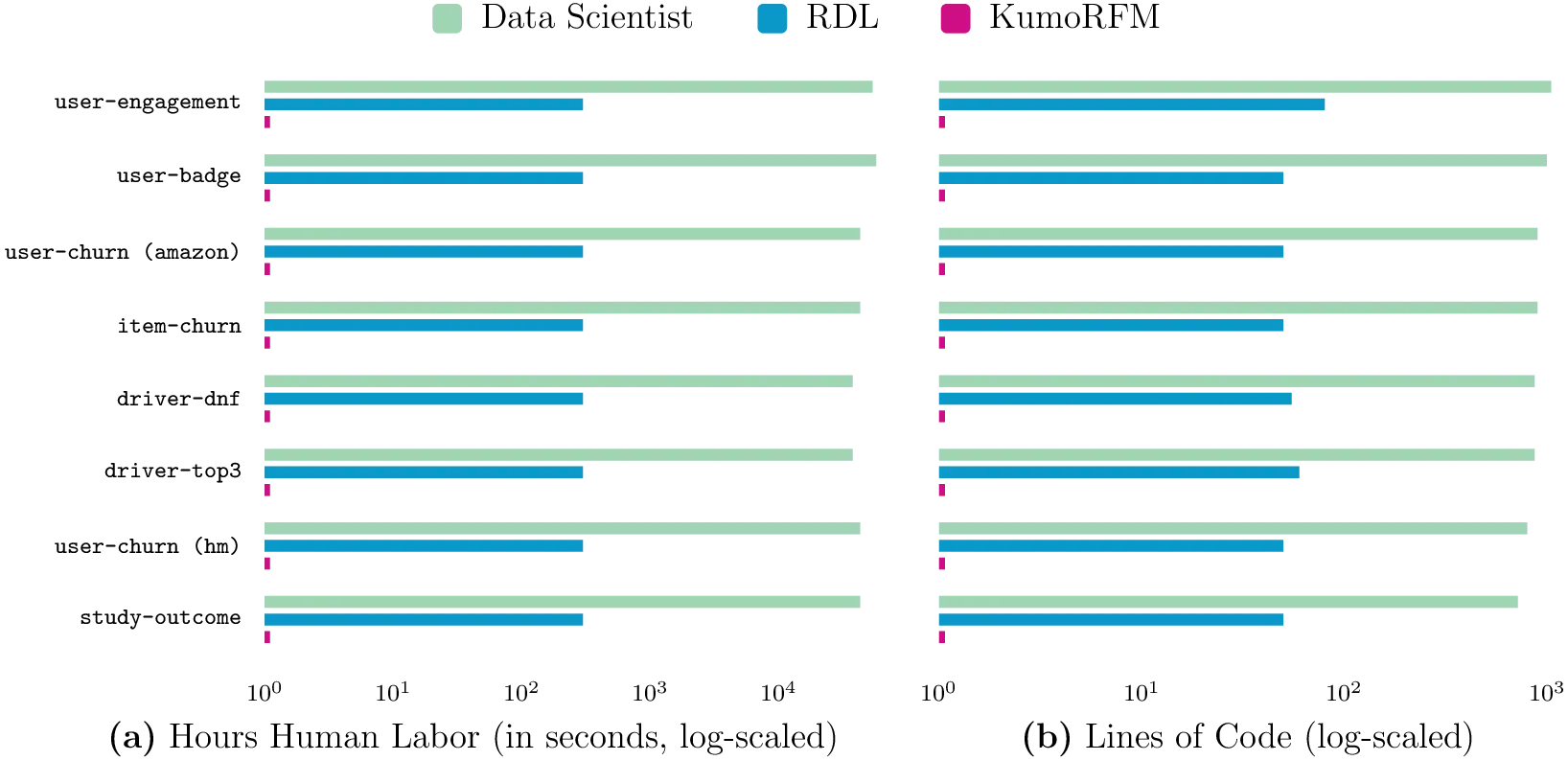

- 디테일하게 KumoRFM 모델을 어떤 데이터를 사용하여 학습시켰는지에 대해 공개하진 않았지만, RelBench 전체에서 제로샷을 수행하였을 때, 지도 학습 기반 ContextGNN보다는 약간 떨어지지만 여전히 훌륭한 결과를 보여줌을 해당 표를 통해 제공하고 있습니다. 하지만 지도 학습 기반 접근방식보다 훨씬 빠르며, 예측 코드 작성이 불필요한 제로코드 솔루션을 제공합니다. 그로부터 최소한의 노력으로도 실시간 예측이 가능한 장점을 언급하고 있습니다.

- 블로그 마지막에 KumoRFM 논문도 찾아보실 수 있으니, 디테일한 내용들을 논문과 같이 읽어보시면서 더 깊은 모델에 대한 분석과 인사이트들을 많이 얻어가셨으면 좋겠습니다.

Sharing new breakthroughs and artifacts supporting molecular property prediction, language processing, and neuroscience

blog link : https://ai.meta.com/blog/meta-fair-science-new-open-source-releases/

paper link : https://arxiv.org/abs/2505.08762, https://ai.meta.com/research/publications/emergence-of-language-in-the-developing-brain/

- 이번은 Meta, FAIR 연구실에서 대규모 분자 데이터셋(OMol25) 및 Universal Model for Atoms (UMA) 를 오픈소스로 제공한 내용의 블로그를 가져왔습니다.

- 최대 1억개의 분자, 생체 분자, 복합체, 최대 350개의 원자로 구성된 MOF 구조 등을 예측할 수 있는 다양한 속성을 가진 시뮬레이션으로 구성된 OMol25은 다른 데이터셋보다 약 10배정도 크며, 다음 시뮬레이션 완료에 6 bilion CPU 시간이 소요되었다고 합니다. 이보다 더 큰 오픈소스 데이터셋은 어디에도 찾기 어려울 것 같네요.해당 데이터셋 다운로드 링크 및 모델, 그리고 논문을 위 블로그에 모두 링킹해두어서 확인해보시면 좋겠습니다.

- 또한 최근 Meta에서는 인지과학분야서 특히 뇌의 활성화 메커니즘을 그대로 LLM등의 거대 모델에 반영하는 연구를 적극적으로 진행하고 있는데 정말 놀랍습니다. 해당 블로그에서는 뇌가 어떻게 AI보다 더욱 효율적으로 언어를 습득하는지의 프로세스를 임상적 실험을 통해 이해하고, 인간처럼 학습하고 추론할 수 있는 LLMs과의 간극을 좁히는 방향성도 논문을 통해 제공하고 있습니다.

- 초기의 뇌를 모방하는 것에 영감을 받았던 AI 모델이, 이제는 뇌의 내부 작동 원리를 밝히는 데 도움이 될 수 있음을 보여줍니다. 도메인 특성 상 어느 정도의 제약 조건들도 필요하겠지만, 불가사의한 분야를 탐구할 수 없었던 이전의 한계점을 AI를 통해 그 너머를 바라볼 수 있다는 사실이 펼쳐진다는 게 저에게는 정말 흥미로운 것 같습니다.

[Contact Info]

Gmail: jhbae1184@akane.waseda.jp

Twitter (X): @jhbae1184